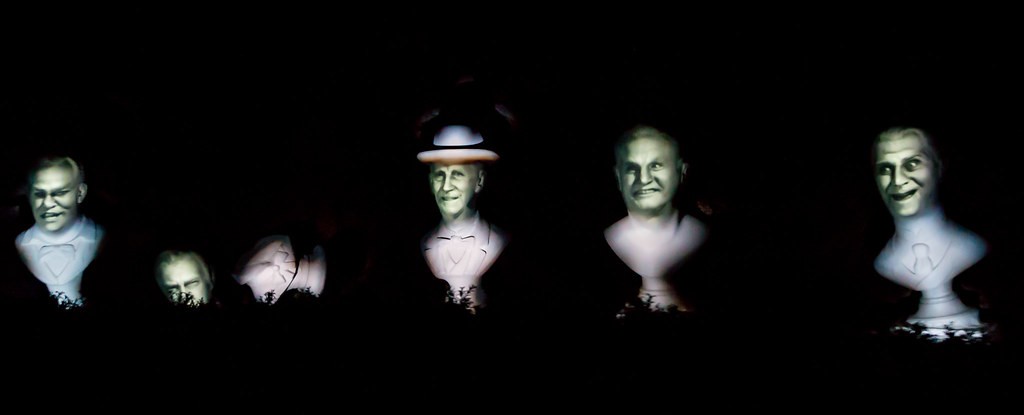

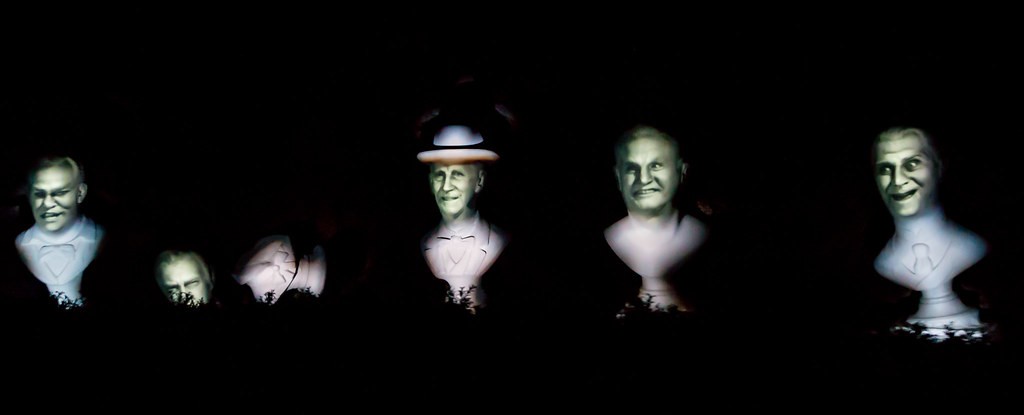

Die Geschichte des 3D Projection Mappings. Der erste dokumentierte Einsatz von Projection Mapping war 1969 in der Haunted Mansion im Disneyland in Kalifornien. Die Haunted Mansion ist eine Attraktion mit zahlreichen optischen Illusionen. Für das erste Projection Mapping wurden fünf Sänger auf 16 Millimeter Film aufgenommen, und auf Büsten von ihnen selbst projiziert. Dies ergab den Effekt als würden die Steinbüsten selbst singen. Obwohl die Illusion für heutige Verhältnisse nicht perfekt war, war der Effekt etwas noch nie zuvor Gesehenes für die Zuseher_innen.

1980 bis 1984 experimentierte Michael Naimark mit neuen Projektionstechniken. Sein Hauptgedanke dabei war, den Projektor beim Abspielen eines Films so zu bewegen wie die Kamera während der Aufnahme, und das im selben Raum mit den selben Objekten. Das Ergebnis der Experimente war die erste immersive Filminstallation Displacements, gezeigt im San Francisco Museum of Modern Art 1984. Die Kamera wurde in einem Raum mit gleichmäßiger Geschwindigkeit um 360 Grad rotiert. Während der Drehung führten Darsteller bestimmte Handlungen aus. Nach der Aufnahme wurde der gesamte Raum, inklusive Möbeln und anderen Objekten mit weißer Farbe besprüht und so in eine Projektionsfläche verwandelt. Der Projektor wurde exakt an die Kameraposition gestellt und synchron zur 360 Grad Aufnahme ebenfalls gedreht. 1991 patentieren zwei Disney-Ingenieure einen Apparat zur digitalen Bemalung eines dreidimensionalen Objekts.

1998 wurde der Begriff Spatial Augmented Reality geboren und in der Publikation „The Office of the Future“ von Rameh Raskar, Greg Welch und Henry Fuchs entwickelt und ausformuliert. Dabei geht es um die Idee Lichtquellen durch Projektoren zu ersetzen und dadurch interaktiv Lichtstimmungen zu erzeugen bzw. alles als Projektionsfläche für Informationen oder Videotelefonie zu nutzen.

„Abstract of the paper : The Office of the Future : A Unified Approach to Image-Based Modeling and Spatially Immersive Displays […]The basic idea is to use real-time computer vision techniques to dynamically extract per-pixel depth and reflectance information for the visible surfaces in the office including walls, furniture, objects, and people, and then to either project images on the surfaces, render images of the surfaces, or interpret changes in the surfaces. In the first case, one could designate every-day (potentially irregular) real surfaces in the office to be used as spatially immersive display surfaces, and then project high-resolution graphics and text onto those surfaces. In the second case, one could transmit the dynamic image-based models over a network for display at a remote site. Finally, one could interpret dynamic changes in the surfaces for the purposes of tracking, interaction, or augmented reality applications. To accomplish the simultaneous capture and display we envision an office of the future where the ceiling lights are replaced by computer controlled cameras and “smart” projectors that are used to capture dynamic image-based models with imperceptible structured light techniques, and to display high-resolution images on designated display surfaces. By doing both simultaneously on the designated display surfaces, one can dynamically adjust or autocalibrate for geometric, intensity, and resolution variations resulting from irregular or changing display surfaces, or overlapped projector images.”(Raskar 2000)

In den folgenden Jahren experimentierten Raskar und Bimber mit tragbaren Smart-Projektoren, Entzerrungen und Materialsimulationen auf realen Objekten. Diese experimentelle Forschung resultierte in den heute gängigen benutzerfreundlichen Computerprogrammen.